随着人工智能与机器人的迅猛发展,轮式机器人在物流配送、清扫保洁、巡检安防等众多领域大显身手。然而,在固态/半固态激光雷达(LiDAR)、4D毫米波雷达等新型传感器逐渐成为量产机器人“标配”的当下,现有公开的机器人数据集在传感器配置、时间同步精度、轨迹真值可靠性以及场景多样性等方面的局限性日益凸显,已难以满足先进导航与建图的研究需求。为此,武汉大学i2Nav团队基于自主研制的轮式机器人平台(传感器完备、时间同步精密),在丰富多样的室内外环境中采集并开源了一套包含10条大尺度序列、总里程超17,000米的高品质多源导航与建图数据集。

精准可靠的导航定位是自主无人地面车辆(UGV)、机器人执行感知、规划与控制等任务的根本基础。基于全球导航卫星系统(GNSS)和惯性导航系统(INS)的GNSS/INS组合导航系统[1-2]能够满足多数室外场景的定位需求。轮式机器人通常配备轮式里程计(ODO),通过构建GNSS/INS/ODO组合导航系统,可有效提升GNSS信号退化或受限场景下的定位精度。而在复杂的室内环境或GNSS信号长时间中断的场景,往往需要引入激光雷达(LiDAR)或视觉同步定位与地图构建(SLAM)[3-4]技术,以确保导航定位的持续可靠性。因此,融合多种优势互补传感器的多源融合导航[5]技术,已成为保障自主机器人在各种场景下稳定、可靠运行的优选解决方案。

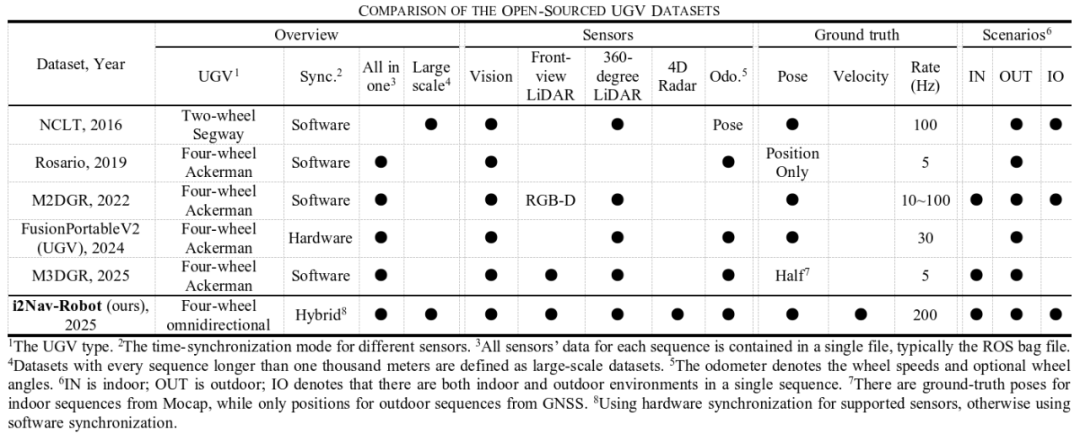

然而,现有机器人数据集存在明显局限,难以满足多传感器融合导航与建图技术的研究需求。首先,现有机器人数据集普遍缺乏已在量产型UGV上装备的新型传感器(如前向半固态LiDAR与4D毫米波雷达)。其次,当前多数数据集仍采用软件时间同步方案,其同步误差在10毫秒级,在多源融合导航中会引入显著定位误差。再次,室外参考真值系统主要依赖实时动态(RTK)定位,其不仅更新频率低、噪声大,且在GNSS信号复杂的场景下容易导致真值不可用或精度不足;室内参考真值则多来自运动捕捉(Mocap)系统,但高速相机的高昂成本限制了其布设范围。最后,受制于参考真值的获取难度,现有数据集场景较为单一,要么集中于GNSS信号良好的室外区域,要么局限于少数配备运动捕捉系统的室内空间。总而言之,现有数据集在传感器配置完备性、时间同步精度、轨迹真值的可靠性与覆盖范围、以及场景多样性方面仍有明显欠缺,如表1所示。

表1 现有机器人数据集特点对比

为此,我们团队精心构建并开源了i2Nav-Robot机器人数据集[6-7]。i2Nav-Robot在以下几个方面进行了重点优化,以期为多源融合导航和建图技术研究提供充分可靠的数据支撑:

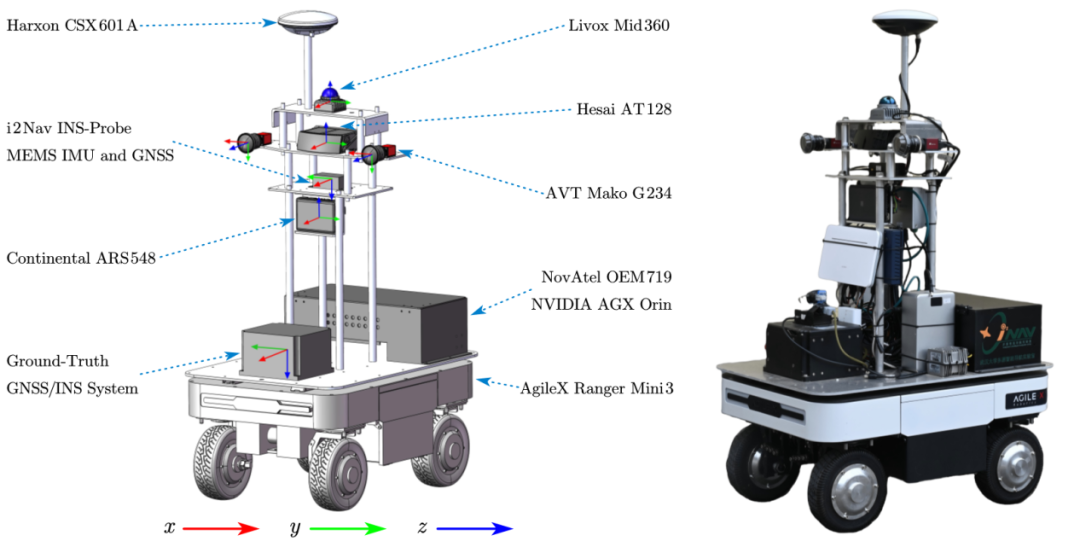

1、完备的多模态传感器集成: 如图1所示,研制的轮式机器人集成前向固态LiDAR、360°环视LiDAR、4D毫米波雷达及双目相机构建多模态感知阵列,同步部署GNSS接收机、IMU与ODO,通过四轮全向移动机器人实现多源传感器空间一体化精密部署,提升复杂环境下UGV的全维度运动感知能力。

图1 多模态传感器集成3D模型与机器人实物图

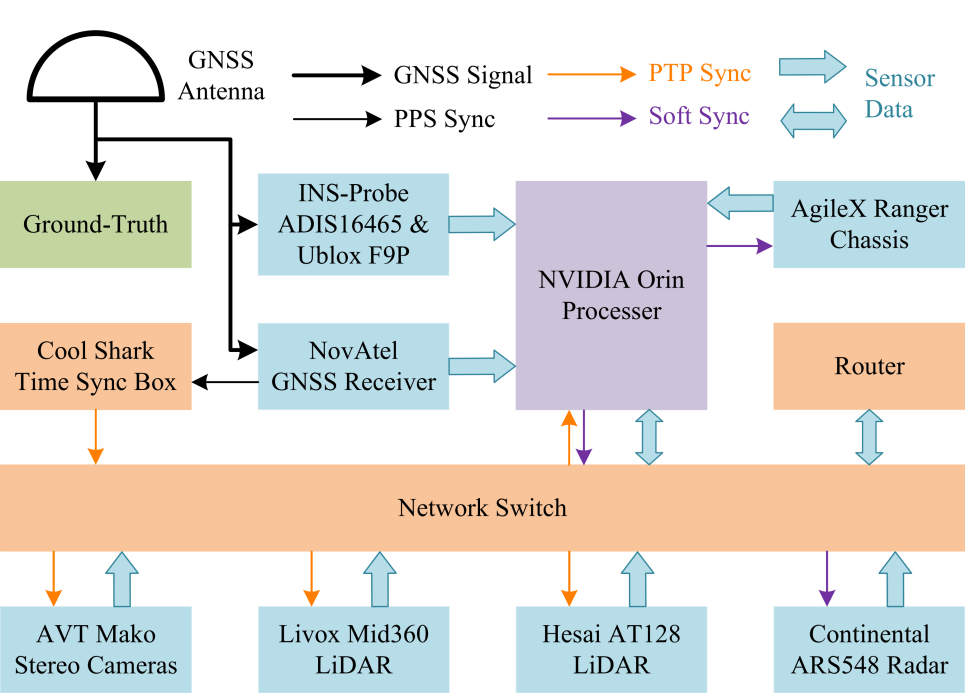

2、精确的时间同步保障: 基于硬件触发与PTP网络同步协议,实现核心传感器LiDAR、相机、IMU和GNSS之间的微秒级同步。针对无同步接口的毫米波雷达及ODO,采用基于速度的离线标定技术,补偿固定时间偏移至毫秒级(≈1ms),图2展示了多源异构传感器的时间同步数据流。

图2 多源异构传感器时间同步数据流

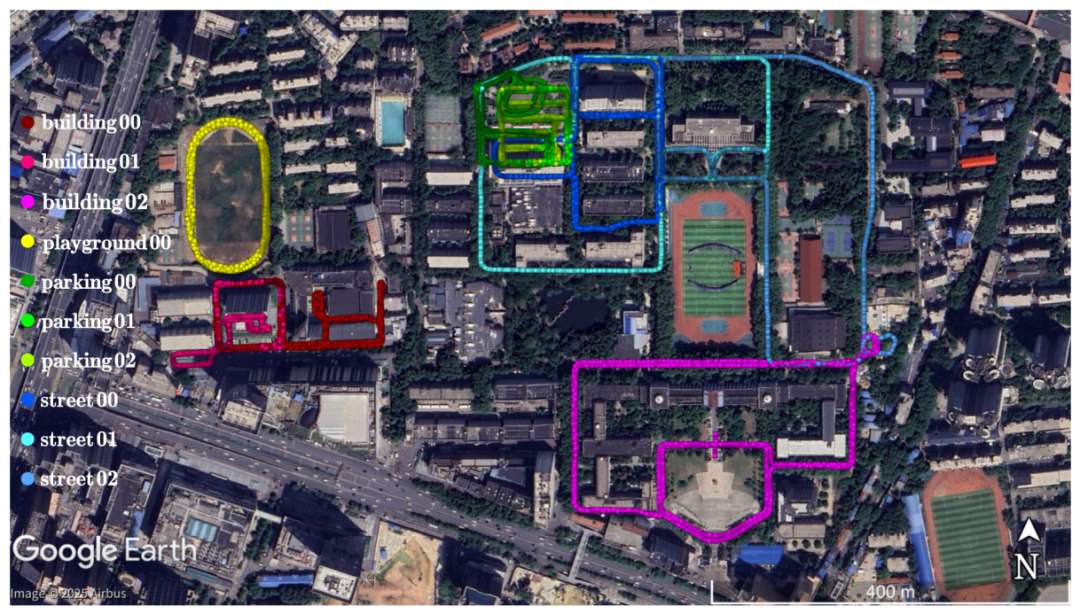

3、丰富多样的大尺度室内外场景: 构建10条大尺度序列数据集,总里程超17,000米(单序列均>1000米),持续时长约14,000秒。数据集采集于武汉大学校园,完整覆盖楼群树荫遮挡的街道、全遮蔽地下停车场及室内外切换建筑群等典型挑战场景,提供多种传感器退化场景,如图3所示。

图3 i2Nav-Robot数据集轨迹分布图

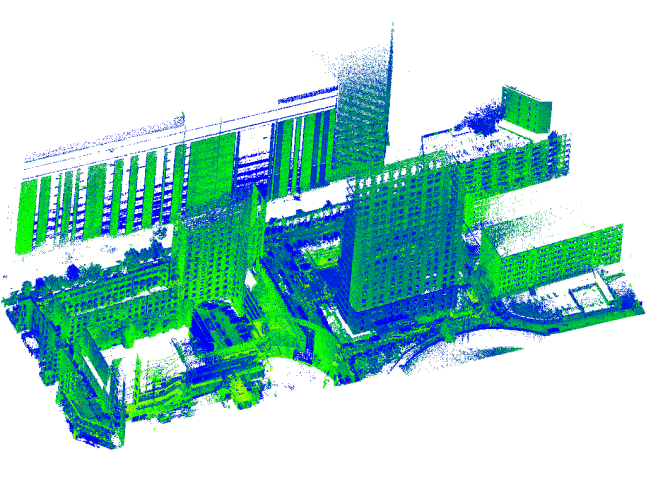

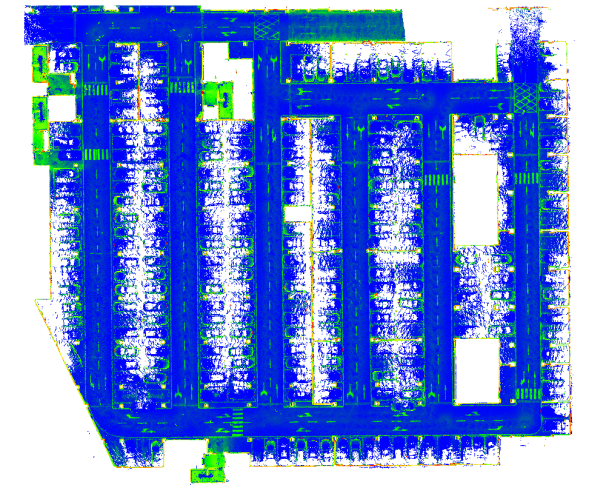

4、全场景厘米级的高精度真值: 依托导航级IMU生成200Hz高精度位姿(位置0.02cm,姿态0.01°,1σ)和速度真值,室外场景采用后处理GNSS/INS紧组合技术,室内等GNSS拒止区域采用LiDAR点云地图匹配/INS融合定位技术,确保室内外全场景厘米级真值全覆盖,图4展示了两个场景的高精度点云地图。

图4 建筑和室内停车场区域的预建高精点云地图

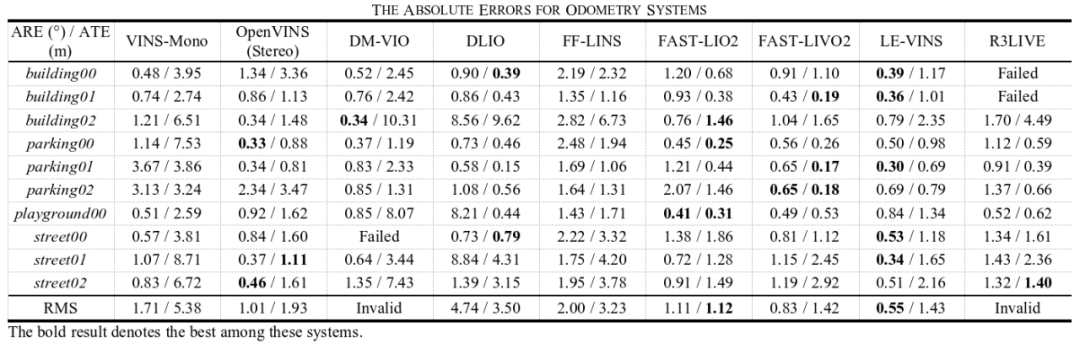

5、全面充分的质量评估验证: 使用超过10种有代表性的开源SLAM算法与多源融合定位算法对数据集进行了全面的测试验证,SLAM算法结果如表2所示。测试结果充分证实了数据集质量,包括时间同步精度、标定参数准确性以及参考真值的可信度。这些开源方案的结果也为广大同行使用该数据集提供了便利。

表2 多源SLAM系统结果评估

开源数据集i2Nav-Robot以及配套的文档和标定文件访问地址: https://github.com/i2Nav-WHU/i2Nav-Robot,相关预印本论文也可通过该链接获取。期待i2Nav-Robot能为无人地面车辆和机器人导航与建图领域从业者提供更丰富的数据资源,共同推动技术向更高精度、更强鲁棒性、更广应用范围演进。

参考文献:

[1] i2Nav Group, “KF-GINS: An EKF-Based GNSS/INS Integrated Navigation System”, 2022.

[Online]: Available: https://github.com/i2Nav-WHU/KF-GINS

[2] i2Nav Group, “OB_GINS: An Optimization-Based GNSS/INS Integrated Navigation System”, 2021.

[Online]: Available: https://github.com/i2Nav-WHU/OB_GINS

[3] i2Nav Group, “FF-LINS: A Consistent Frame-to-Frame Solid-State-LiDAR-Inertial State Estimator”, 2023.

[Online]: Available: https://github.com/i2Nav-WHU/FF-LINS

[4] i2Nav Group, “LE-VINS: INS-Centric Visual-Inertial Navigation System With LiDAR Enhancement”, 2024.

[Online]: Available: https://github.com/i2Nav-WHU/LE-VINS

[5] i2Nav Group, “IC-GVINS: A Robust, Real-time, INS-Centric GNSS-Visual-Inertial Navigation System”, 2022.

[Online]:https://github.com/i2Nav-WHU/IC-GVINS

[6] i2Nav Group, “i2Nav-Robot: A Large-Scale Indoor-Outdoor Robot Dataset for Multi-Sensor Fusion Navigation and Mapping”, 2025. [Online]:https://github.com/i2Nav-WHU/i2Nav-Robot

[7] i2Nav Group, “i2Nav-Robot: A Large-Scale Indoor-Outdoor Robot Dataset for Multi-Sensor Fusion Navigation and Mapping,” Aug. 15, 2025, arXiv: arXiv:2508.11485. doi: 10.48550/arXiv.2508.11485.

版权所有:武汉大学多源智能导航实验室(微信公众号:i2Nav) 当前访问量: 技术支持:武汉楚玖科技有限公司